深度学习模型包管理工具

本节介绍深度学习模型包管理工具的使用方法。

工具介绍

深度学习模型包管理工具是Mech-MSR软件提供的管理深度学习模型包的工具,可对Mech-DLK 2.6.1及之后版本导出的深度学习模型包进行优化,并对运行模式、硬件类型、模型效率、模型包状态进行管理。此外,该工具还可以监控PC的GPU使用率。

当工程中使用了深度学习模型包推理步骤时,可将模型包先导入到深度学习模型包管理工具,然后在该步骤中使用。将模型包提前导入该工具,可提前完成模型包的优化。

功能入口

你可以通过以下方式打开该工具:

-

新建或打开工程后,依次单击软件菜单栏中。

-

在软件的工程编辑区,单击“深度学习模型包推理”步骤上的配置向导按钮。

-

在软件的工程编辑区,选中“深度学习模型包推理”步骤,然后在步骤参数栏中单击模型包管理工具下的打开编辑器按钮。

界面描述

该工具界面中各选项字段描述如下:

| 字段 | 描述 | ||

|---|---|---|---|

缓存模型包名称 |

导入的模型包名称。 |

||

使用工程 |

使用模型包的Mech-MSR工程。 |

||

模型包类型 |

模型包的类型,如“文本检测”、“文本识别”等。

|

||

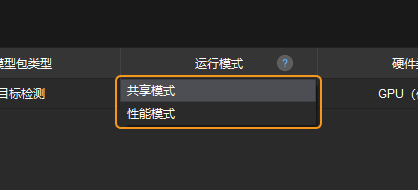

运行模式 |

推理时模型包的运行模式,包括共享模式和性能模式。

|

||

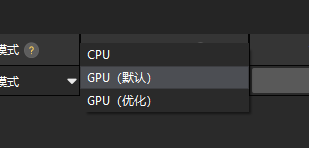

硬件类型 |

使用模型包进行推理时使用的硬件的类型,包括GPU(默认)、GPU(优化)、CPU。

|

||

模型效率 |

可对模型包推理效率进行配置。 |

||

模型包状态 |

模型包的状态,如“优化中”、“就绪” 、“优化失败”等。 |

常见操作

本节介绍深度学习模型包管理工具的常见操作。

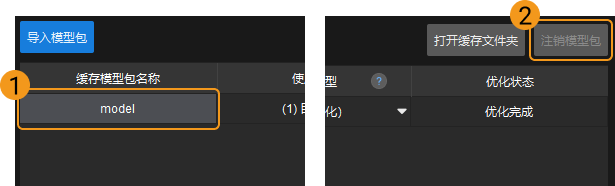

导入深度学习模型包

-

打开深度学习模型包管理工具,在其界面左上角单击导入模型包按钮。

-

在弹出的文件选择窗口中选中想要导入的模型包,然后单击打开按钮,该模型包即可出现在工具的列表中。

|

导入深度学习模型包时,GPU驱动的最低版本要求为472.50(不建议使用500以上版本的GPU驱动,可能导致深度学习步骤运行时间存在波动),CPU的最低要求为英特尔第6代Core。当硬件条件不满足时将出现深度学习模型包导入失败的情况。 |

注销深度学习模型包

如需注销已导入的深度学习模型包,需先选中该模型包,然后单击工具界面右上角的注销模型包按钮,即可注销该模型包。

|

当模型包处于优化中或正在使用(使用该模型包的工程正在运行)状态时,该模型包不能被注销。 |

切换运行模式

如需切换模型包推理的运行模式,可在深度学习模型包管理工具的运行模式字段下单击 ![]() 按钮,然后选择共享模式或性能模式。

按钮,然后选择共享模式或性能模式。

|